為什麼寫這篇

今天,我想從「知識」的角度重新理解 AI。

PS: 這篇文章,在國外有引起一些討論,絕大部分的學者,包括 Cynefin Framework 的作者 Dave Snowden 都是認可的,但是在國內某研討會投稿被拒絕了。所以,大家斟酌看吧。我拆成三篇,這是其中的一篇,有人看我再繼續 PO,排版也是很累的。

最近我發表了一些關於 AI 的觀察與提醒,有些朋友因此誤以為我是在反對 AI。 事實上,我很早就投入 AI 的應用與研究。只是當外界一面倒地追捧 AI 時,我選擇退一步,從不同面向重新思考它的本質與定位。

這篇文章聚焦在一個核心問題:

AI 在人類知識結構中,究竟扮演什麼角色?

我想透過 DKIW 知識金字塔(Knowledge Pyramid)這個模型,釐清 AI 的運作邏輯、理解它在知識體系中的位置,以及那些「人類無法被取代」的部分。 這些正是 AI 時代,人類自我提升與努力的關鍵所在。

同時,我也希望我們不要對 AI 抱持過度的期待或恐懼。

理解它,面對它,善用它,治理它。

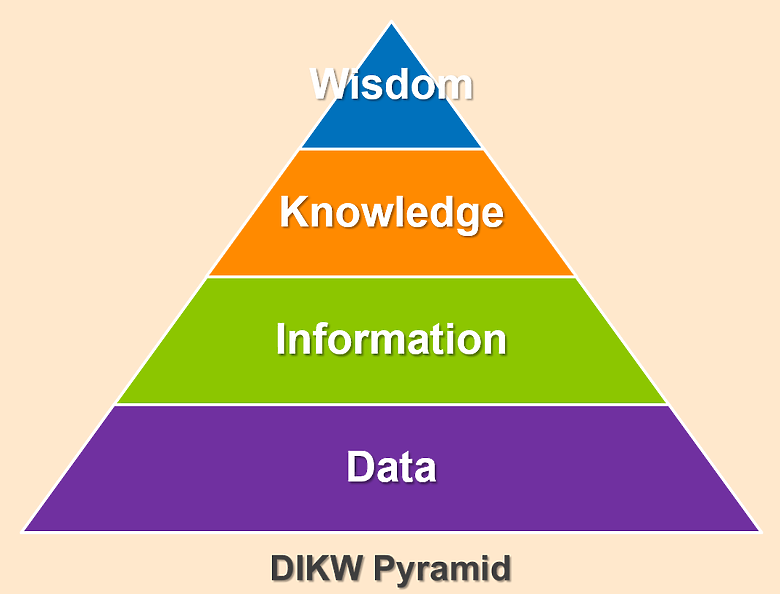

1️⃣ 利用 DIKW 模型幫助我們理解什麼是「智慧」

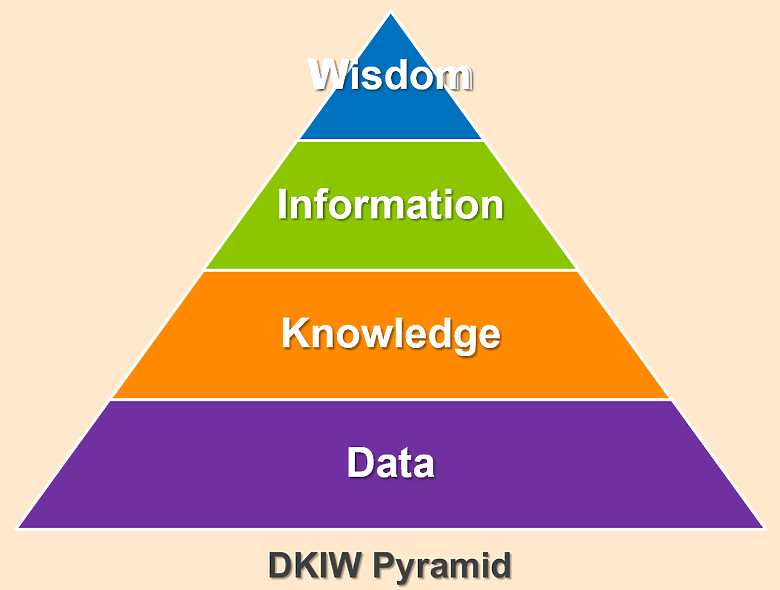

DIKM 模型是知識管理與資訊科學領域中的一個常見階層模型,代表:Data → Information → Knowledge → Wisdom

- Data(資料):尚未整理的觀察與測量

- Information(資訊):具脈絡與意義的資料

- Knowledge(知識):可應用的理解模式

- Wisdom(智慧):基於價值與判斷的抉擇能力

這個模型也叫做 知識金字塔(Knowledge Pyramid) 或 智慧階梯(Wisdom Hierarchy),用來說明從原始資料到高層次智慧的轉化過程。

這模型也讓我們看清楚一件事:智慧並不是資料處理的終點,而是價值判斷的起點。

但是,在台灣,有個很傷筋的事,我們常將「智慧」與「智力」混用。

我們將 Artificial Intelligence 翻譯成人工智慧,將 Smart Phone 翻譯成智慧型手機。但是它們是不同概念,尤其我們在面對知識體系衝擊時,更需要明確的界定:

👉 智力(Intelligence),指的是處理資訊、推理、學習與分析的能力。它可以訓練、可以測量,也可以模擬。像是記憶、邏輯推演、歸納能力,這些都是 AI 擅長的領域。

👉 智慧(Wisdom),則是一種整合了價值觀、情境理解、經驗沉澱與判斷的能力。它不只是會做選擇,更是知道什麼時候不該選、什麼事情不該做,也能看出人與人之間的關聯、影響與後果。

簡單說:

智力只管「能不能做」;智慧則會問「該不該做」

或者可以說

Intelligence: Do the thing right; Wisdom: Do the right thing.

智慧(Wisdom)包含價值判斷、道德責任與人性洞察,AI 確實展現出強大的智力,但它缺乏智慧。因此,「人工智慧」這個翻譯並不恰當,應稱為人工智能或人工智力才更準確。

科學家花費很多時間、財力去研究,才證明依賴 AI 會讓自己變笨。我媽媽從小就告訴我「抄別人的作業,自己怎麼學得會」她沒讀什麼書,智力遠不如這些科學家,但是她的智慧卻遠勝過這些科學家。

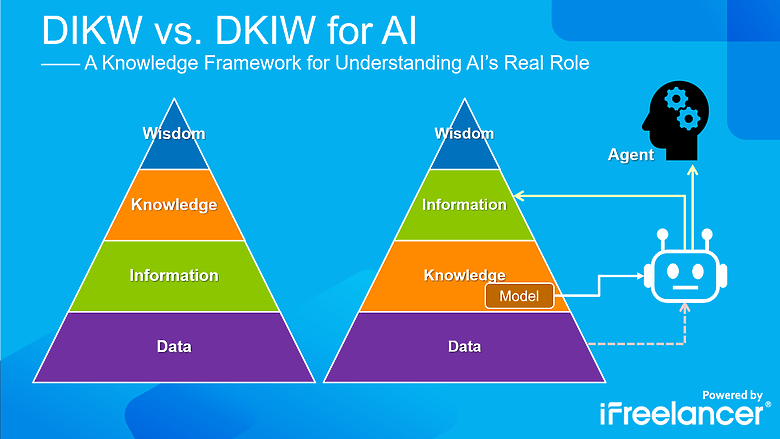

2️⃣ DIKW 模型無法定位 AI 的角色

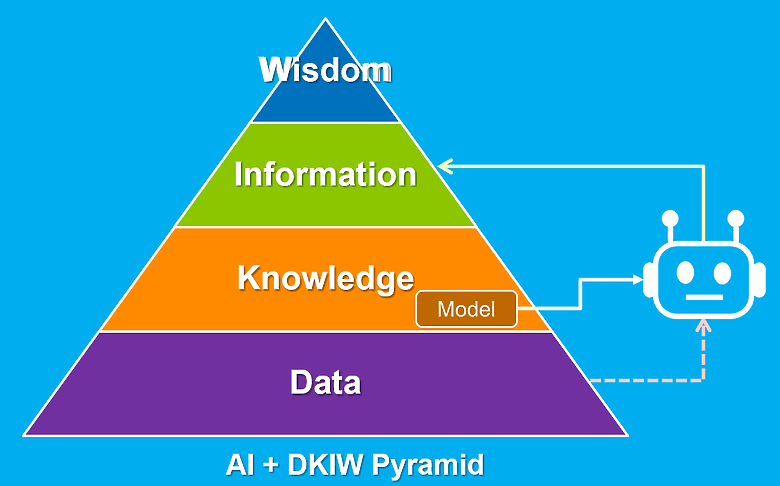

Intelligence 並不屬於 DIKW 金字塔的一部分,我試著尋找適當的位置,將 AI 放入其中,會發現它的位置與角色極其模糊且矛盾:AI 並不是從資料出發、逐層走向智慧的存在。它反而是:

- 使用既有的知識模型(K)

- 對人類餵給它的資料(D)進行處理

- 產出語意連貫的資訊(I)

DKIW:Data → Knowledge → Information → Wisdom

也就是說:

「資訊」不是從「資料」自然演化而來的,而是靠「知識」去詮釋資料,才有「資訊」的產生。

這樣的理解也與知識理論學者 Dave Snowden 的觀點不謀而合。他曾指出:

My position was that knowledge is the means by which data becomes information, and that knowledge exists on a spectrum between tacit and explicit. — 《Cynefin: A Tale That Grew in the Telling.》P.42

這句話,本身就打破了 DIKW 的直線層級邏輯。

也就是說:資訊的產生,仰賴知識的解釋與加工,而不是資料的堆疊。

不過,我覺得 Dave Snowden 應該不滿意這個架構,他應該會比較喜歡 DKIM,Meaning,而不是 Wisdom。😏

改成這個結構之後,我們就能真實的反映了 AI 的工作路徑:

AI 是運用「知識」將「資料」轉化為「資訊」的系統

而所謂的「知識」就是所謂的「模型」(Model),也就是人類事先整理好、餵給 AI 的大量知識。

我常說:「訓練模型,其實就是 AI 的職業訓練。」

- 你餵它很多卡通圖片,它就能畫出那種風格。

- 你餵它大量音樂素材,它就會開始作詞作曲。

- 你餵它一堆法律文書,它就會瞎掰一些判例給你。

3️⃣ AI 處理的是知識與資訊,無法主動建構資料與判斷智慧

從 DKIW 的結構來看,AI 處理的是中段(Knowledge → Information):- 它可以應用知識

- 它可以生成資訊

- 但它無法主動理解資料的脈絡與價值,更無法進行判斷

AI 為什麼無法「處理」 Data?

技術上,AI 確實會接收資料(data)作為輸入,並進行處理。 但這些資料都是人類預先收集、整理、標註與分類的。AI 本身沒有感官、沒有觀察能力、也無法主動決定資料的意義。AI 不是觀察者,而是使用既定知識來「轉譯」資料成資訊的系統。 它無法決定看什麼,更無法理解「為什麼要看這個」。

AI 為什麼無法處理 Wisdom?

AI 沒有價值觀,也無法承擔選擇後的責任。 它不會懷疑任務、不會質疑輸出目標,也無法思考行動的意義。它只會根據預設目標與訓練邏輯,產出最佳化結果, 卻無法回答「這樣做是否應該」「為誰做」「要不要停」。

因此:

AI 是知識的執行器,不是判斷的主體。 它可以做事,但不會選擇為何而做。

或許你會說:「會呀,AI會判斷啊,它也會懷疑、拒絕任務,不合理的他不會做啊!有時候我叫它畫圖,它也會告訴我違反規定,拒絕執行」。

是的,但是,是否違反規定,什麼時候該拒絕,那也是人類事先告訴它的,不是它自己判斷的。

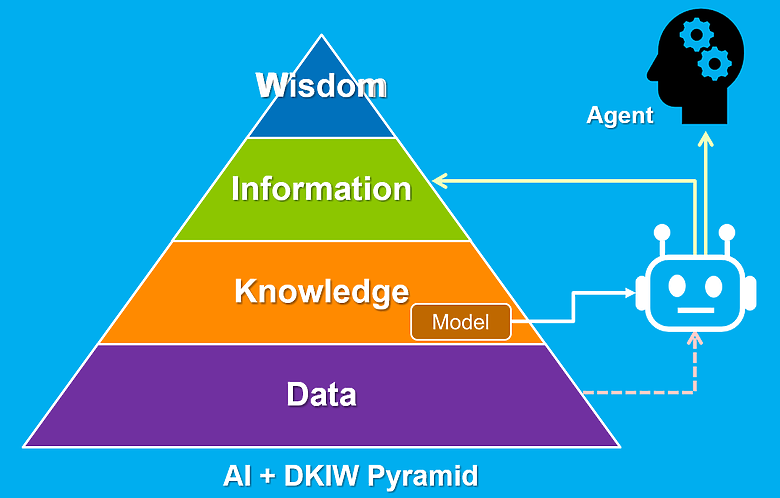

4️⃣ 即使是 AI Agent,本質上也只是知識的自動調度器

隨著 AutoGPT、BabyAGI、Open Interpreter 等「AI Agent」的出現,許多人開始以為 AI 已經具備主動性,甚至有「選擇能力」。但實際上,這些系統仍只是:

- 多模組協作的知識應用機制

- 任務目標與評估標準由人類事先定義

- 執行與調整依賴內部演算法的最適化邏輯

所謂的「Agentic AI」,只是知識流程的自動化延伸,不是真正的代理人。

✅ 小結

1️⃣ DIKW 模型說明智慧的層次,也讓我們理解 AI 不應稱作「人工智慧」2️⃣ AI 的角色更適合用 DKIW 描述,它是知識驅動的資訊生成器

3️⃣ AI 無法主動處理資料(D),也無法承擔抉擇與價值判斷(W)

4️⃣ 就算是 AI Agent,本質仍是自動化工具,而非主體性存在

這就是我為什麼從知識面談 AI。

不是為了批評技術,而是希望我們在應用它之前,先搞清楚它是什麼,不是什麼。

在所有 AI 產品名稱中,我最喜歡微軟的命名: Copilot

是的,它就是 Copilot 。

如果你也關注 AI 的角色與限制,歡迎一起討論。