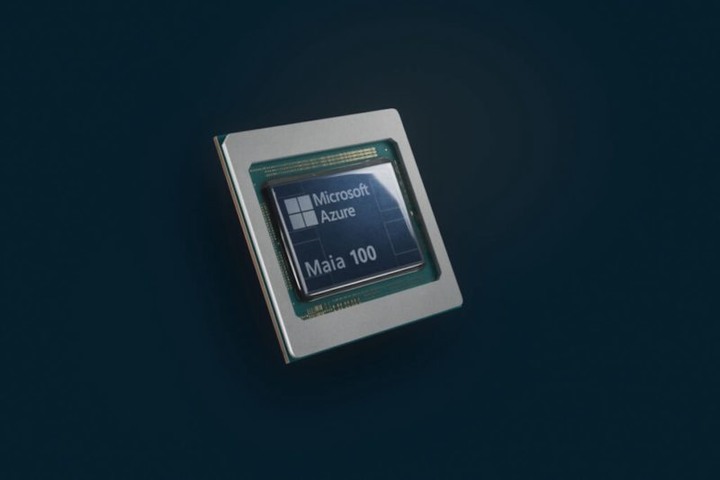

微軟自研 AI 晶片傳聞未曾停過,在一年一度 Microsoft Ignite 2023 大會上,終於發表用於資料中心的 AI 晶片 Azure Maia 100 和雲端運算處理器 Azure Cobalt 100

/// Maia : 昴宿四(金牛座20), 一顆藍色星座

Azure Maia 是一款 AI 加速器晶片,用於 OpenAI 模型、ChatGPT、Bing、GitHub Copilot 等 AI 工作負載,Azure Maia 100 則是該系列第一代產品,採取 5 奈米製程生產。Azure Cobalt 為 Arm 架構的雲端運算處理器,配備 128 個運算核心,與目前幾代 Azure Arm 晶片相比,效能提升 40%,為 Microsoft Teams、Azure SQL 等服務提供支援,這 2 款晶片均由台積電生產,微軟已在設計第二代版本

領導團隊開發新晶片的微軟 AHSI(Azure Hardware Systems and Infrastructure)副總裁 Rani Borkar 指出,微軟已在 Bing 和 Office 產品測試新款 AI 晶片,微軟主要 AI 合作夥伴、ChatGPT 開發商 OpenAI 也以 GPT 3.5 Turbo 進行測試。Azure Maia 和 Azure Cobalt 預計明年初正式用於微軟資料中心,成為 Azure 雲端運算服務的一部分。

Rani Borkar 接受外媒採訪表示,對具規模的微軟而言,優化和整合硬體的每個要素可提供最佳運算效能,同時避免供應鏈瓶頸,Azure Maia 和 Azure Cobalt 可為客戶提供基礎設施新的選擇

自研晶片可獲得硬體性能和價格優勢,同時避免公司過度依賴任何一家供應商。目前 AI 產業高度依賴 NVIDIA GPU 因此凸顯問題,亞馬遜和 Google 已有自研晶片的具體成果,亞馬遜 2015 年收購以色列晶片新創 Annapurna Labs,為客戶提供雲端和 AI 晶片的服務,Google 從 2018 年起允許客戶採用自研晶片 TPU(Tensor Processing Unit),微軟急起直追終於跟上腳步。

除此之外,微軟也將在明年向客戶提供採用 NVIDIA H200 GPU 和 AMD MI300X GPU 的虛擬機器(VMs)服務,2 款晶片都能用於執行 AI 任務。

==