只要 100 鎂 / 3000 - 150鎂 /4500 台幣左右

https://www.reddit.com/r/Amd/comments/15t0lsm/i_turned_a_95_amd_apu_into_a_16gb_vram_gpu_and_it/

Ryzen 4600G/5600G BIOS 把內顯使用記憶體調成 16GB 就可以了

有人號稱ASROCK 主板內顯記憶體上限可達 64GB

可以運行大量 AI 應用程序,包括 Stable Diffusion、FastChat、MiniGPT-4、Alpaca-LoRA、Whisper、LLM 和 LLaMA

maya95 wrote:跟這篇回文中影片連結所說的 類似使用方式

使用 4600G/5600G...(恕刪)

-> [01站內文] 給台積電代工

把顯示記憶體拓展到最大 在把AI所需程序全都丟進去

就不用再回最慢的儲存裝置讀取資料

所以速度會比插只有12GB顯示記憶體的卡快

彈幕濃!

類似效果

類似效果skiiks wrote:

把顯示記憶體拓展到最大 在把AI所需程序全都丟進去

就不用再回最慢的儲存裝置讀取資料

所以速度會比插卡只有12GB顯示記憶體快

最近還有AI開源社群紛紛為蘋果M2改寫AI引擎為ARM架構

為的就是M2集成CPU中 192GB記憶體 可以當顯示記憶體用

可以放進整個AI需要的檔案 可以隨時調整AI

這種使用方式

雖然總體運算能力低於6張4090(24GB顯示記憶體x6或x8)

但可以放進整個AI需要的檔案

不需要從儲存裝置反覆載入 做到即時調整

雖然運算較慢 但在價格 功耗 以及使用難度上 蘋果M系列更為優異

尤其價格 M2 192GB價格18萬起跳 頂規28萬

4090光價格 6張x5~6萬 = 30~36萬 還不包含CPU 記憶體 主機板

但跟4070(TI)比是在爆12G顯示記憶體下

4070(TI)可能無法出圖而獲得5600G較快

但還是有方法可以解決爆記憶體的問題

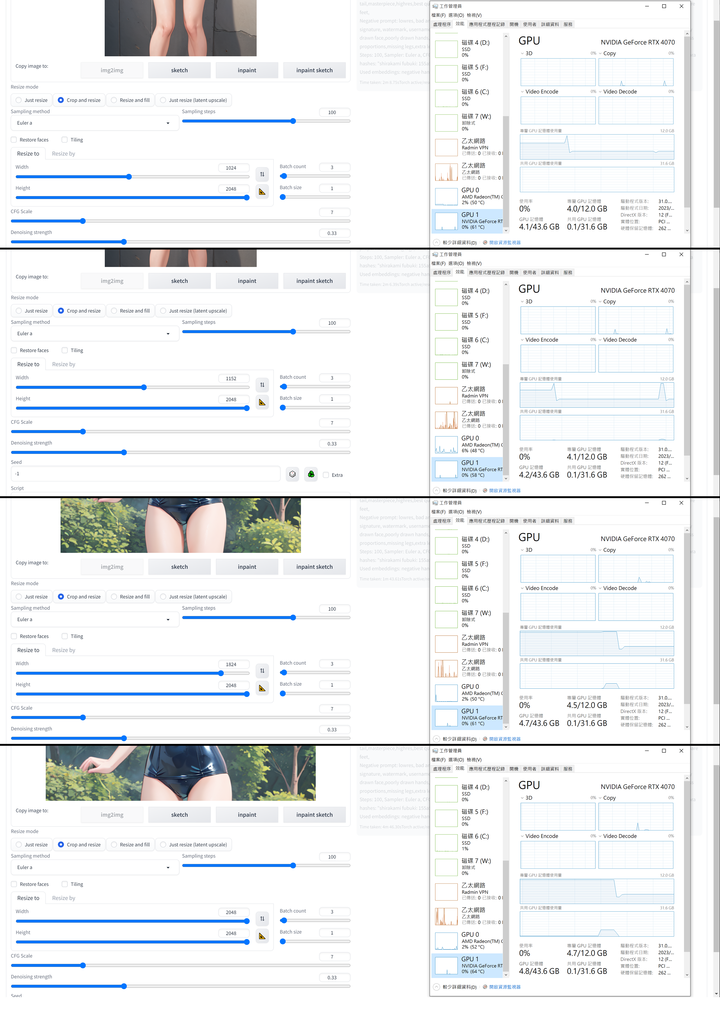

不過可能只限AMD+N卡(我是7950X3D+64G RAM+4070),A卡的話我就不清楚了

之前試過INTEL+N卡(13950HX+64G RAM+4080Laptop)記憶體爆太多還是會出不了圖

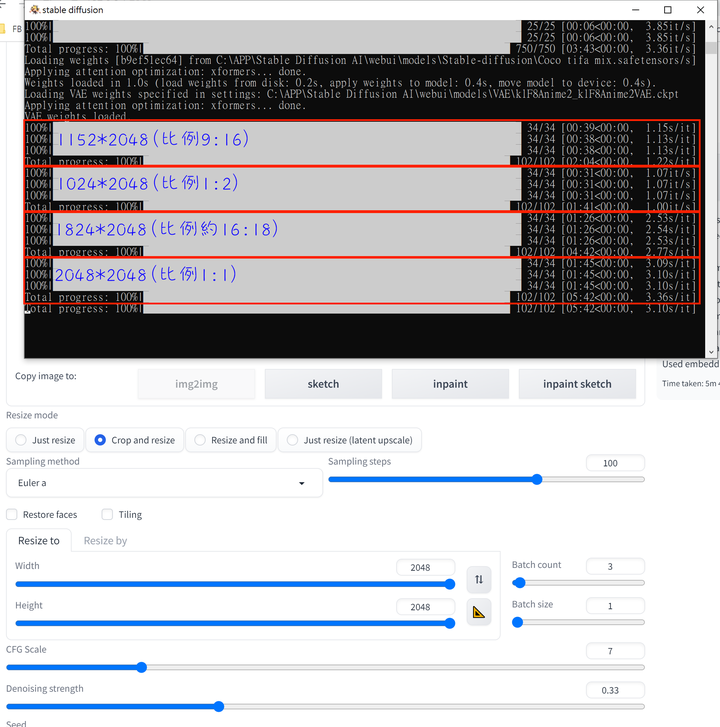

以上是圖生圖

如果是文生圖那更沒有爆記憶體問題

因為超過特定解析度後,生成的圖會有極高機率畸形

以像素量來說上限大概就一百萬,而這只要約8G的顯示記憶體就夠了

想更大就要採用圖生圖

文生圖的話......

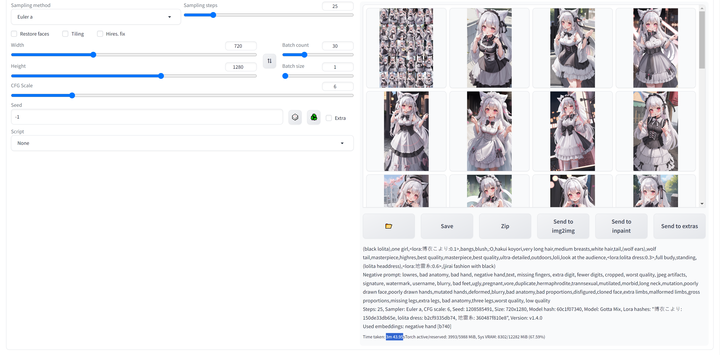

RTX 4070 720*1280 25步 30張

耗時約3分44秒

老實說論速度是完全比不上4070

更別說拉滿2048*2048 APU要跑多久

但也算解除之前心中疑問,APU分夠記憶體還是能跑

內文搜尋

X