擦鞋童 wrote:

這次我美金就不隨便換...(恕刪)

輝達已經反映過了,8/28財報不錯也不會漲

目前降息循環要買其他股票

擦鞋童 wrote:

我明明看空的,就是手...(恕刪)

Sinfield wrote:

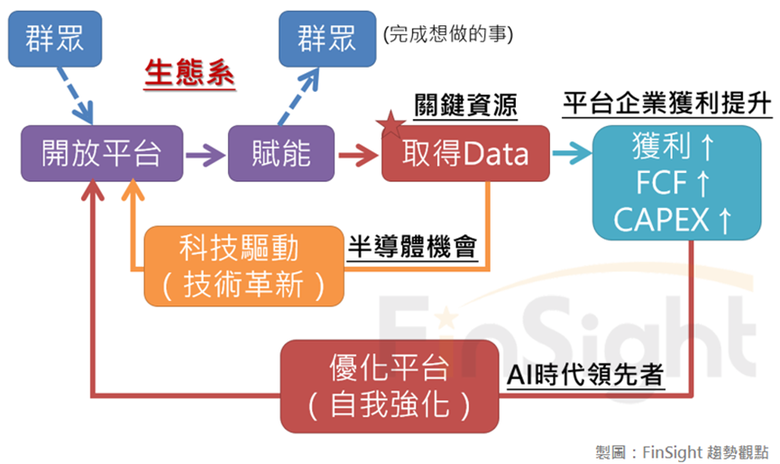

至於趨勢

算力與AI的需求是等比級數,而不是等差級數

很多數學不好的忽略這一點

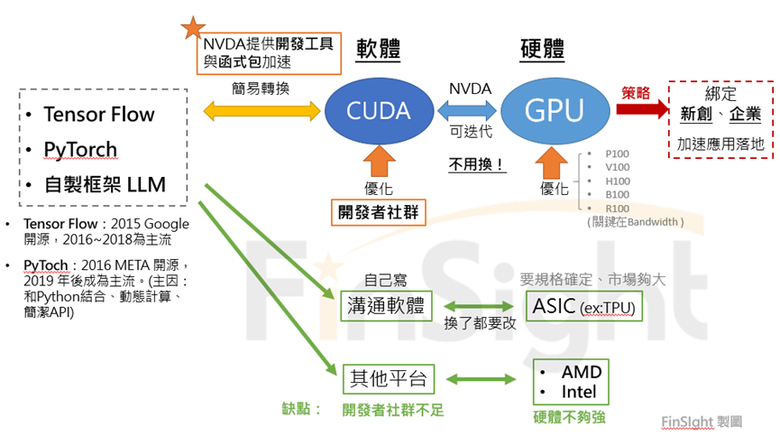

Mata老闆老祖說這一代訓練要10萬張H100來訓練LLma

下一代就要30萬張

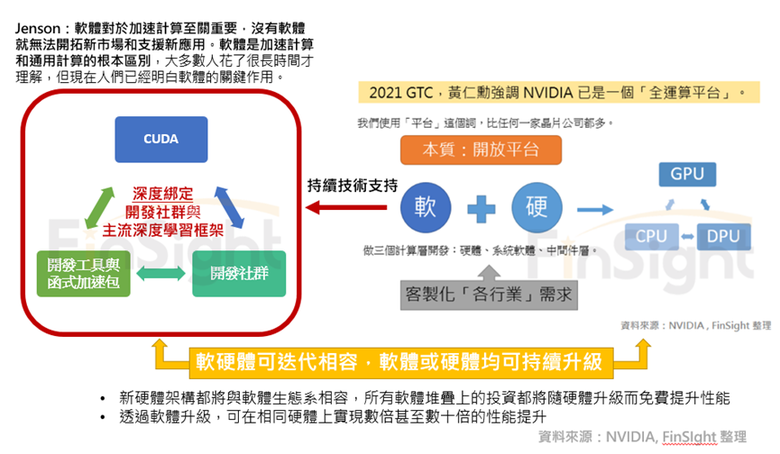

老黃的黃氏定律則是要遠超摩爾定律

AI晶片算力10年要成長1000倍(10的三次方倍)

我之前有PO過美國的創投分析GPU只能用一代就落伍了

因為更新的AI需要更多"倍"的算力(而不是更"多")

只能買最新的晶片才能把成本降低

AI用指數的速度成長

老黃拚盡全力用指數的發展來配合

那些競爭對手才剛發展

哪來的指數型的爆發壓過NVDA???

AI基建還沒結束

NVDA有兩三年的好過日子一點也不為過